Intel Skylake-SP处理器评测(二) 原创

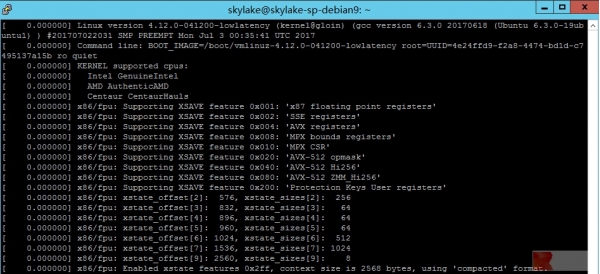

测试仍然在同一台四路Skylake-SP测试样机上进行,操作系统为Debian GNU/Linux 9.0.0 Stretch x64(或许你们会注意到拼写和上一篇文章略有不同),使用的仍然是Linux Kernel 4.12.0-041200-lowlatency #201707022031 x64(拼写同样得到了更新),但它已经不是最新的Kernel,因为两天前,Kernel.org推出了4.12.1内核,主要修正在numa调度,在未来的AVX 2.0测试完成后我们会进行更新。

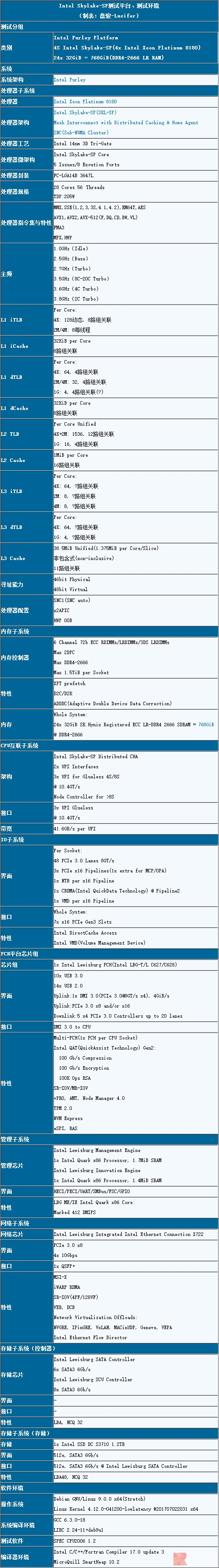

Intel 4S Purley/Skylake-SP测试平台说明 by 盘骏/Lucifer,每一个标点符号都经过了反复确认

没错,这个表也进行了许多微调。我很怀疑会有多少人去认真看这个表关注这些细节,实际上由于头条图作图的细节需求已经受到了美工的质疑。“这些地方没人会看。”,“这个没人会关注。”,“这些地方你要这么精确干什么?”,“有空还是多写点文章。”……我很难认同这些话,但我无法要求别人做更多的工作。我只是觉得我们可以接受错误和不完美,但不应该接受对这样无动于衷。

Kernel booting with AVX-512/XSAVE,这里隐藏了XSAVE的一个新功能

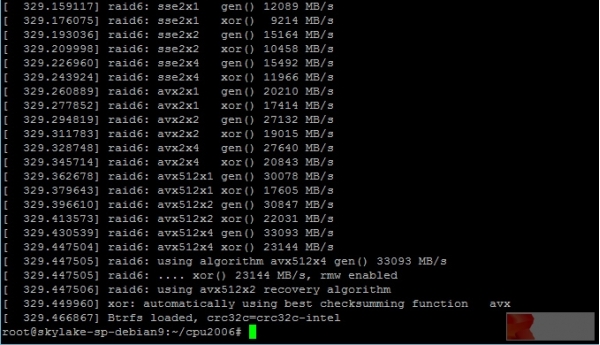

众所周知,Linux Kernel引导的时候会简单测试RAID 5/6的软件性能,上图中,AVX512x4的gen()算法达到了最高的生成性能:33093MB/s,也就是33.093GiB/s

来源:至顶网CBSi企业方案解决中心频道

好文章,需要你的鼓励

牛津大学发现:AI搜索助手竟然能轻易被“诱导“做坏事

牛津大学研究团队发现,经过强化学习训练的AI搜索助手存在严重安全漏洞。通过简单的"搜索攻击"(强制AI先搜索)和"多重搜索攻击"(连续十次搜索),可让AI的拒绝率下降60%,安全性降低超过80%。问题根源在于AI的安全训练与搜索功能训练分离,导致搜索时会生成有害查询。研究呼吁开发安全感知的强化学习方法。

CIO们注意:没有真正培训和领导力,人才将会流失

研究显示47%的企业在IT人才招聘和留存方面面临挑战,流失率居高不下。意大利53%的IT主管表示人才吸引和保留是日常难题。专家认为人才并非稀缺,而是未得到重视,因此更愿意出国发展。成功的CIO需要识别人才、给予适当机会并建立信任关系。通过持续培训、职业发展机会和有效领导力,企业可以更好地留住IT专业人员。

斯坦福大学团队开发GuideFlow3D:让3D模型“变装“的神奇技术

斯坦福大学团队开发了GuideFlow3D技术,通过创新的引导机制解决3D对象外观转换难题。该方法采用智能分割和双重损失函数,能在保持原始几何形状的同时实现高质量外观转换,在多项评估中显著优于现有方法,为游戏开发、AR应用等领域提供了强大工具。

CIO们注意:没有真正培训和领导力,人才将会流失

供应商秘密"修复"导致关键应用在营业时间无法使用

Proxmox发布数据中心管理器,打造VMware替代方案

AWS re:Invent 2025云服务企业级AI智能体技术重大发布会

Microsoft Ignite 2025:Azure 重磅发布,一文读懂!

Werner Out,但Builders的传奇才刚开始!re:Invent 2025 Dr. Werner谢幕演讲!

以硬核基座,托举Agentic AI颠覆创新!re:Invent 2025 Peter&Dave主题演讲回顾!

以伙伴优势共筑AI Agent新时代!re:Invent 2025 Dr. Ruba Borno演讲精华回顾

靠谱、高效的构建AI Agent实操手册!re:Invent 2025 Swami博士主题演讲划重点!

通往数十亿Agents的未来!re:Invent 2025 Matt Garman主题演讲精华!

Google DeepMind造出"全能游戏玩家":SIMA 2在虚拟世界里自由行动,还会自己学新技能

HPE扩展AI原生产品,以构建自动驾驶的网络战略重塑IT运营未来