新华三H3C R4700 G3高密机架服务器评测 原创

前面我们说过,新华三H3C UniServer R4700 G3可以最高支持至TDP 205W的Xeon SP Platium 8180M,双路配置下最多可以提供56个硬件核心和112个硬件线程,最多3.0TiB DDR4-2666内存支持能力,我们可以看到一共具有24个DDR4 DIMM,合12个内存通道:

中央即为处理器与内存区域,来源:H3C

我们收到的机器搭配的是12条SK. Hynix的16GiB DDR4-2666内存;银白色散热器下方就是CPU

需要特别指出的是,由于散热能力的差别,不是所有的1U服务器都能支持最顶级的处理器以及最大容量的内存,H3C R4700 G3可以支持Xeon Platium 8180M和128GiB单条的LR DIMM,这是一些其他1U服务器所不具备的。

在扩展性上,H3C R4700 G3也有其特别之处:

H3C R4700 G3提供了两个全高全长(FHFL)的PCIe 3.0 x16插槽,除了可以连接高速IO设备之外,它还能支持企业级的GPU:

H3C R4700 G3的PCIe Riser上具有一个8PIN的PCIe电源插座,猜测其为输出电能到GPU加速卡

EPP 8PIN PCIe电源提供的功率为可达150W,在这里似乎有些大材小用,因为H3C谦逊地标注R4700 G3支持最大功率120W的GPU加速卡,目前可以选择的型号有NVIDIA的M4和M4000。很多1U机架服务器并不能支持企业级GPU,或者说,功耗比较高的GPU。

除了两个自由的PCIe x16扩展槽之外,前面介绍过R4700 G3还提供了一个专用于板载阵列卡的PCIe x8界面,至于网络,R4700 G3和其他的服务器有些不太一样:

蓝色表示这个可以安全免工具维护操作,意味着这个4口RJ45网络接口单元是可以拆卸的

首先特别的一点是,R4700 G3的板载网络可以非常方便地进行更换和重新配置,它采用了一种很少见的子卡设计:

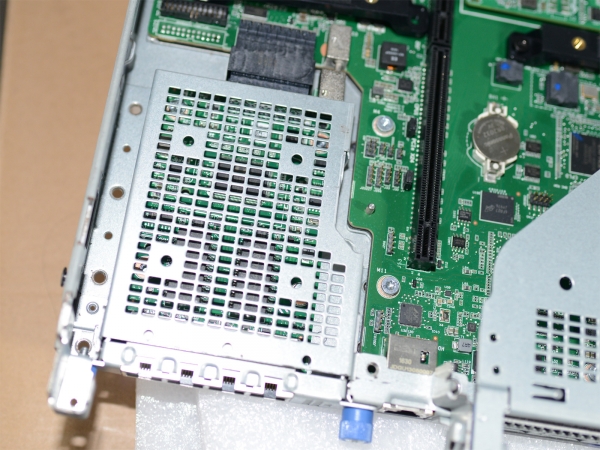

不知道原名的我们将其称为网卡笼,大量的空间以及孔洞可以提供充足的散热能力

这个网络子卡+网卡笼的设计不仅仅可以免工具维护——它还是服务器免抽取的,只要在后面板拧螺丝就可以了。

第二点特别的地方在于,这个部件是可以带电热插拔的,我不清楚是否很多人都清楚这一点,但按照网卡芯片的设计,它是具有这个特性的。

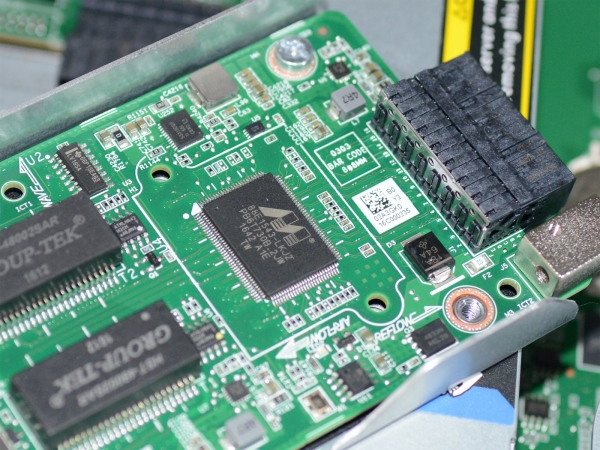

Marvell 88E1543芯片,这其实只是一个不太重要的四口1Gb以太网PHY芯片……

Marvell 88E1543芯片,这其实只是一个不太重要的四口1Gb以太网PHY芯片……

第三点特别之处在于,这个网络子卡实际上只是一个PHY芯片,网卡实际上是包含在主板的Intel PCH芯片上,学名Intel Ethernet Connection X722,它其实是一块基于Intel X710独立40Gb以太网卡改良的片内网卡,具有相似的规格和一致的驱动:

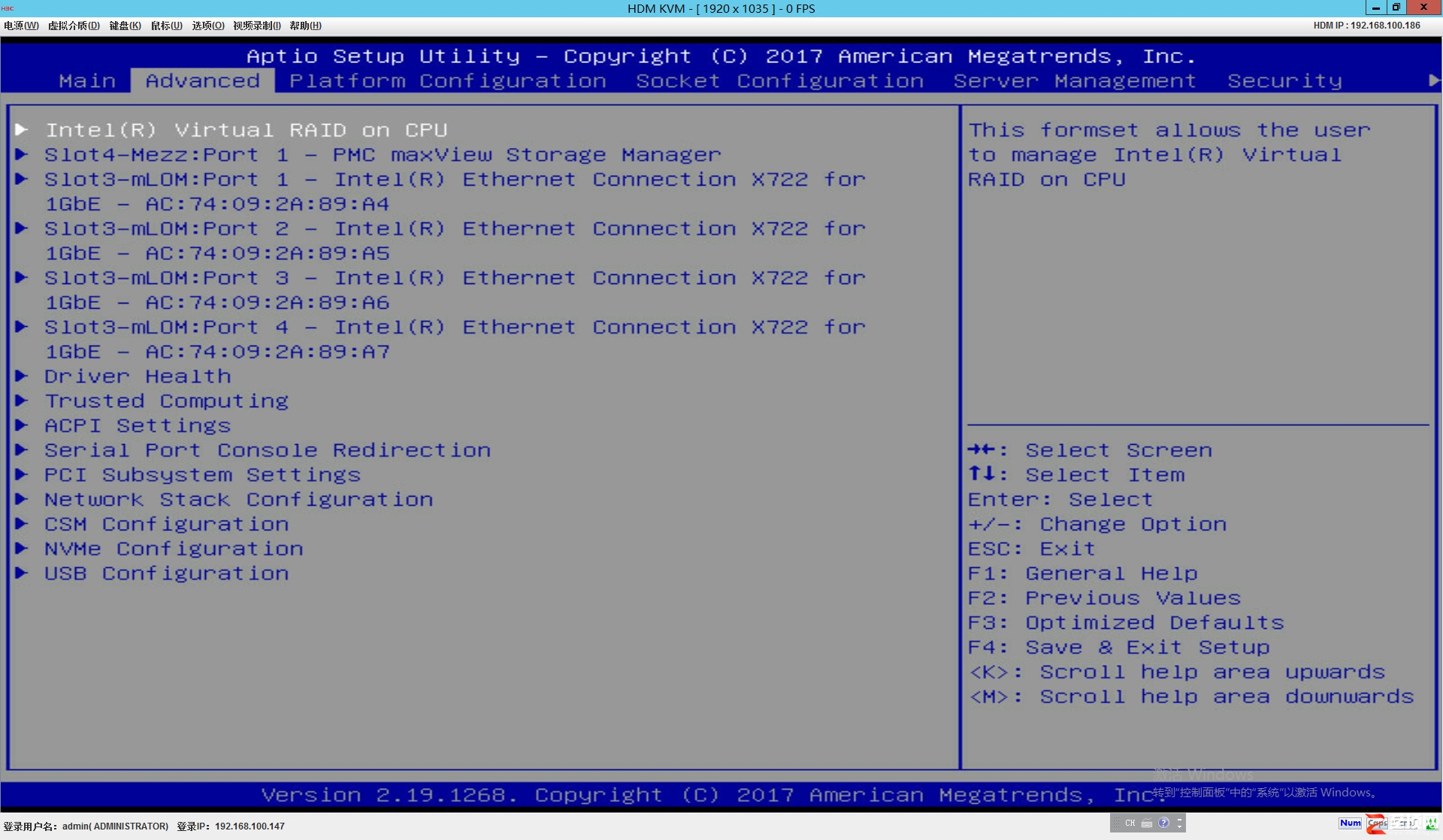

BIOS里显示为四个Intel Ehternet Connection X722 for 1GbE,这是因为插入的是四口RJ45 1Gb模块

BIOS里显示为四个Intel Ehternet Connection X722 for 1GbE,这是因为插入的是四口RJ45 1Gb模块

这个网卡具有多种接口配置,H3C目前提供的有三种:四口千兆铜口、双口万兆光口、双口万兆电口。原则上,系统可以支持最多四口万兆。通过切换不同的模块,系统就可以方便地实现不同的接口形式和传输速率。

最后是两点R4700网络配置的特质:一点是这个网卡通过专用的PCIe界面与CPU直连,而不是与以前的板载网卡一样连载延迟更高的PCH芯片组上,另一点是这个新网卡可以支持iWARP(Internet Wide Area RDMA Protocol) RDMA功能,提供了一种极为快速的互联能力,并且不管使用什么样的接口子卡都具备。遗憾的是,本次我们不对其进行测试。关于H3C R4700 G3的内部设计我们就介绍到这里,下面我们将开始介绍我们进行的测试。

好文章,需要你的鼓励

Spotify年度盘点2025首次推出多人互动功能“盘点派对“

Spotify年度总结功能回归,在去年AI播客功能遭遇批评后,今年重新专注于用户数据深度分析。新版本引入近十项新功能,包括首个实时多人互动体验"Wrapped Party",最多可邀请9位好友比较听歌数据。此外还新增热门歌曲播放次数显示、互动歌曲测验、听歌年龄分析和听歌俱乐部等功能,让年度总结更具互动性和个性化体验。

NVIDIA联手多所高校推出SpaceTools:AI机器人有了“火眼金睛“和“妙手回春“

NVIDIA联合多所高校开发的SpaceTools系统通过双重交互强化学习方法,让AI学会协调使用多种视觉工具进行复杂空间推理。该系统在空间理解基准测试中达到最先进性能,并在真实机器人操作中实现86%成功率,代表了AI从单一功能向工具协调专家的重要转变,为未来更智能实用的AI助手奠定基础。

英国SAP用户因商业套件重启授权迷局感到困惑

英国SAP用户表示,Business Suite的授权和定价复杂性正在影响这一云应用新模式的推广。英国和爱尔兰SAP用户组织调查显示,仅27%的用户熟悉今年2月推出的重新设计版Business Suite。61%的受访者认为授权和定价模式是最需要了解的问题。用户在制定从传统系统迁移的商业案例时面临困难,特别是从ECC平台迁移到S/4HANA需要完整的业务转型。ECC主流支持将于2027年结束。

机器人学会“三思而后行“:中科院团队让AI机器人告别行动失误

这项研究解决了现代智能机器人面临的"行动不稳定"问题,开发出名为TACO的决策优化系统。该系统让机器人在执行任务前生成多个候选方案,然后通过伪计数估计器选择最可靠的行动,就像为机器人配备智能顾问。实验显示,真实环境中机器人成功率平均提升16%,且系统可即插即用无需重新训练,为机器人智能化发展提供了新思路。

Spotify年度盘点2025首次推出多人互动功能"盘点派对"

英国SAP用户因商业套件重启授权迷局感到困惑

AWS发布Graviton5定制CPU,为云工作负载带来强劲性能

美光放弃Crucial品牌:告别消费级存储市场

手机里的NPU越来越强,为什么AI体验还在原地踏步?

如何使用现有基础设施让数据做好AI准备

IT领导者快问快答:思科光网络公司首席数字信息官Craig Williams分享AI转型经验

Anthropic CEO警告AI行业泡沫化,批评"YOLO"式投资

雅虎利用AI实时总结橄榄球比赛精彩内容

押注AI智能体,奇奇科技跨越十年的“换挡”与远航

联想天禧AI及创新终端设备在2025 AIE博览会获两项大奖,引领个人AI体验创新

豆包手机助手调整部分AI能力 呼吁保障用户AI使用权