新华三H3C R4700 G3高密机架服务器评测 原创

SPEC CPU是一个应用广泛的大型CPU性能测试项目,SPEC是标准性能评估公司(Standard Performance Evaluation Corporation)的简称,这是一个由计算机厂商、系统集成商、大学、研究机构、咨询等多家公司组成的非营利性组织,这个组织的目标是建立、维护一套用于评估计算机系统的标准。除了SPEC CPU之外,SPECviewperf系列产品也是常见的测试工作站/图形卡部件所用到的测试软件,类似的项目还有如SPECjbb 2015(Java应用性能)、SPEC SFS2015(文件服务器性能)等。

SPEC CPU是SPEC组织推出的一套CPU子系统评估软件,目前最新版本是SPEC CPU2017,于2017年6月20日发布,不错相关测试还在准备之中,本次测试中我们使用的仍然是SPEC CPU2006。SPEC CPU2006包括CINT2006和CFP2006两个子项目,分别用于测量整数性能和浮点性能。SPEC CPU的测试组件均来源于真实的应用程序,并经过修改以降低对IO子系统的影响,在测试中,测试系统的处理器、内存子系统和使用到的编译器(SPEC CPU测试提供的是源代码,并且允许测试用户按照规则进行一定的编译优化)都会影响最终的测试性能,而I/O(磁盘)、网络、操作系统和图形子系统对于SPEC CPU2006的影响非常之小。

SPEC CPU2006包括了12项整数运算和17项浮点运算,除此之外,还有两个随机数产生测试程序998.sperand(整数)和999.specrand(浮点),它们虽然也包含在套件中并得到运行,但是它们并不进行计时以获得得分。这两个测试主要是用来验证一些其他组件中会用到的PRNG随机数生成功能的正确性。各个测试组件基本上由C和Fortran语言编写,有7个测试项目使用了C++语言,而Fortran语言均用来编写浮点部分。SPEC CPU2006以一台Sun Ultra Enterpirse 2工作站作为基准参考系统,系统基于一颗296MHz的UltraSPARC II处理器,测试的得分就表明这个项目中测试系统相对基准系统性能的比值。

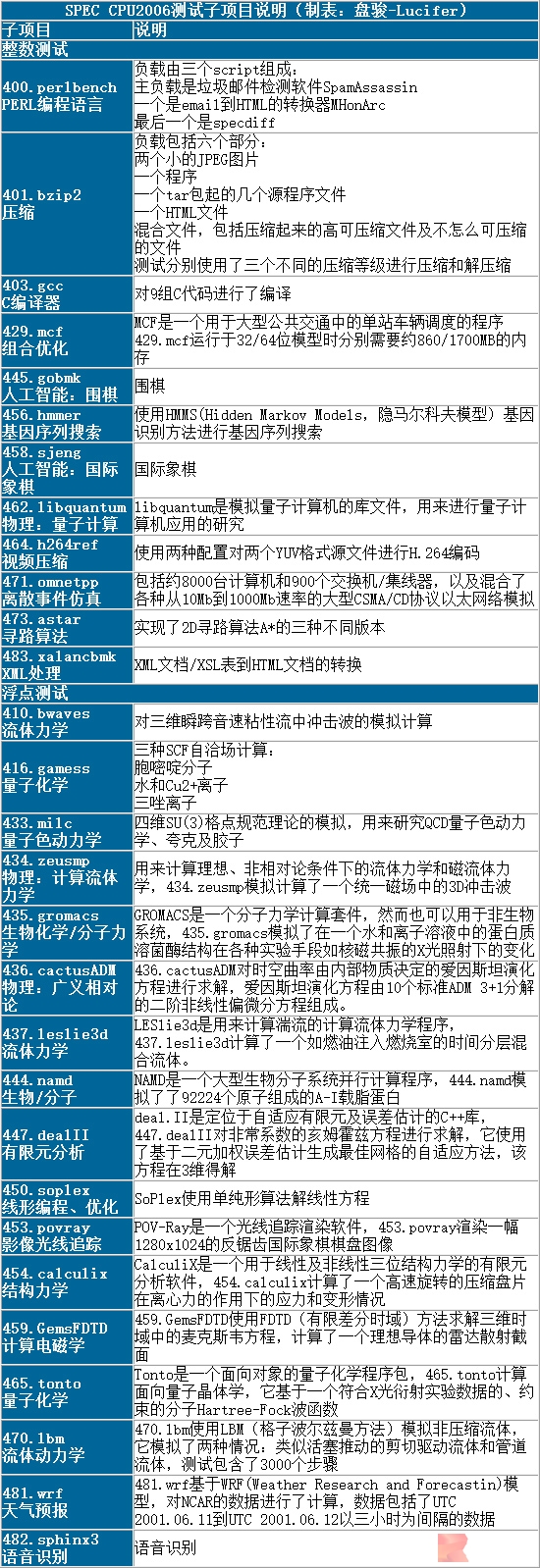

SPEC CPU2006测试子项目 by 盘骏/Lucifer

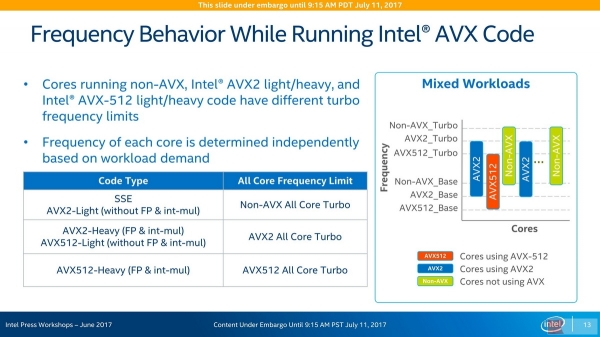

测试使用了当前这一个阶段我们的基准测试配置,包括基于当然仍然算还比较新的Intel C&Fortran Compiler编译器17.0 update 3,以及MicroQuill的SmartHeap 10.2堆管理器。H3C UniServer R4700 G3的处理器支持AVX512,但基于AVX-512代码的测试仍然在进行中。对于Intel Skylake-SP处理器而言,运行不同扩展指令集的代码会和功耗、Turbo Boost具有一个复杂的影响关系。必须得说,这种复杂性对用户来说整体上是更好的,但它也让理解系统的运行状态变得更加麻烦。如下图所示:

Intel Skylake-SP上,Turbo Boost睿频技术具有6个峰值频率,按照负载的不同而不同

实际上具有的频率还更多,因为原有的Turbo Boost睿频技术本身就让系统在不同数量核心负载时具有不同的频率,因此按照non-AVX/AVX2/AVX-512的不同,这个频率表的规模要乘以三倍,在下一页的配置表中,我们给出了被测试服务器的基准频率表,也就是运行非AVX2、AVX-512代码时的频率表这个。在运行AVX-512代码的时候,不管是基频,还是Turbo频率,全线都会有所降低,这有时会带来一些负面影响。

好文章,需要你的鼓励

Spotify年度盘点2025首次推出多人互动功能“盘点派对“

Spotify年度总结功能回归,在去年AI播客功能遭遇批评后,今年重新专注于用户数据深度分析。新版本引入近十项新功能,包括首个实时多人互动体验"Wrapped Party",最多可邀请9位好友比较听歌数据。此外还新增热门歌曲播放次数显示、互动歌曲测验、听歌年龄分析和听歌俱乐部等功能,让年度总结更具互动性和个性化体验。

NVIDIA联手多所高校推出SpaceTools:AI机器人有了“火眼金睛“和“妙手回春“

NVIDIA联合多所高校开发的SpaceTools系统通过双重交互强化学习方法,让AI学会协调使用多种视觉工具进行复杂空间推理。该系统在空间理解基准测试中达到最先进性能,并在真实机器人操作中实现86%成功率,代表了AI从单一功能向工具协调专家的重要转变,为未来更智能实用的AI助手奠定基础。

英国SAP用户因商业套件重启授权迷局感到困惑

英国SAP用户表示,Business Suite的授权和定价复杂性正在影响这一云应用新模式的推广。英国和爱尔兰SAP用户组织调查显示,仅27%的用户熟悉今年2月推出的重新设计版Business Suite。61%的受访者认为授权和定价模式是最需要了解的问题。用户在制定从传统系统迁移的商业案例时面临困难,特别是从ECC平台迁移到S/4HANA需要完整的业务转型。ECC主流支持将于2027年结束。

机器人学会“三思而后行“:中科院团队让AI机器人告别行动失误

这项研究解决了现代智能机器人面临的"行动不稳定"问题,开发出名为TACO的决策优化系统。该系统让机器人在执行任务前生成多个候选方案,然后通过伪计数估计器选择最可靠的行动,就像为机器人配备智能顾问。实验显示,真实环境中机器人成功率平均提升16%,且系统可即插即用无需重新训练,为机器人智能化发展提供了新思路。

Spotify年度盘点2025首次推出多人互动功能"盘点派对"

英国SAP用户因商业套件重启授权迷局感到困惑

AWS发布Graviton5定制CPU,为云工作负载带来强劲性能

美光放弃Crucial品牌:告别消费级存储市场

手机里的NPU越来越强,为什么AI体验还在原地踏步?

如何使用现有基础设施让数据做好AI准备

IT领导者快问快答:思科光网络公司首席数字信息官Craig Williams分享AI转型经验

Anthropic CEO警告AI行业泡沫化,批评"YOLO"式投资

雅虎利用AI实时总结橄榄球比赛精彩内容

押注AI智能体,奇奇科技跨越十年的“换挡”与远航

联想天禧AI及创新终端设备在2025 AIE博览会获两项大奖,引领个人AI体验创新

豆包手机助手调整部分AI能力 呼吁保障用户AI使用权