Intel Broadwell-EP处理器评测

看完Core核内的改进之后,我们再来看看Uncore核外的改动,首先是核心互联架构的改进,大致上,下面这张图表格里面的内容都属于Uncore领域:

基于最新的14nm制程,Broadwell-EP现在具有22个核心,数量上,比上一代Haswell的18个核心增加并不是太多,实际上,同期推出的Broadwell-EX最多有24个核心。我们咨询了Intel,回答是:“我们认为22个核心数量对用户是最合适的”,听起来非常官方。当然,缘由我们也可以理解,那就是:功耗,Broadwell-EX的TDP要高那么一些,而其降低的频率被附加的额外线路(用于更多路CPU系统)抵消,因此,Broadwell-EP的核心数量要少那么两个。这可以理解。

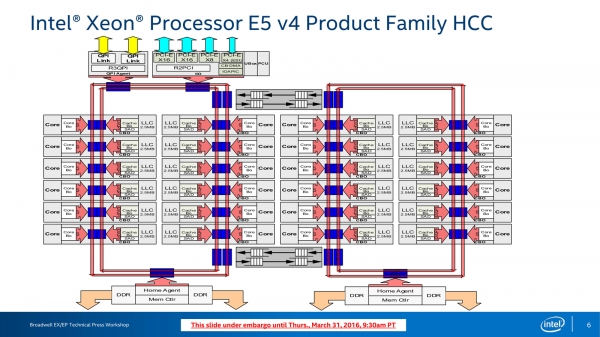

Intel Xeon E5-2600 v4 HCC,High Core Count,高核心数量

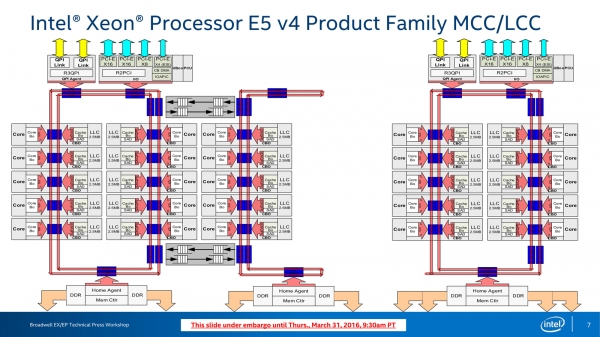

Intel Xeon E5-2600 v4 MCC/LCC,Medium/Low Core Count,中/低核心数量

可见,与上一代Haswell-EP其实非常相像:

Haswell-EP核心内部互联,这个进化只有十核心及以上核心数量的型号(HCC)才具有

Broadwell-EP和Haswell-EP一样,只有在HCC和MCC上才有四环形总线设计,LCC只有两条环形总线。HCC/MCC中,CPU核心被分为了两组,每组通过一对环形总线连接,然后在两组核心之间通过Buffered Switch(缓冲交换机)互联,Buffered Switch会引入延迟,根据Haswell-EP Workshop上笔者的问询,Intel方回答是,Buffered是FIFO的设计,并具有4~5个时钟周期的延迟。在这次笔者重新确认了一下,Intel的回答改为了3~4个时钟周期,并再次重复了这个确认。这种延迟天生将CPU分为了两个略有距离的两个部分,一般情况下用户可以忽略这个不同,但对于延迟极为敏感的应用,Intel从Haswell-EP开始还准备了一个新的Cluster-on-Die的工作方式:

在具有2个Home Agent的SKU(HCC与MCC)才具有Cluster-on-Die特性

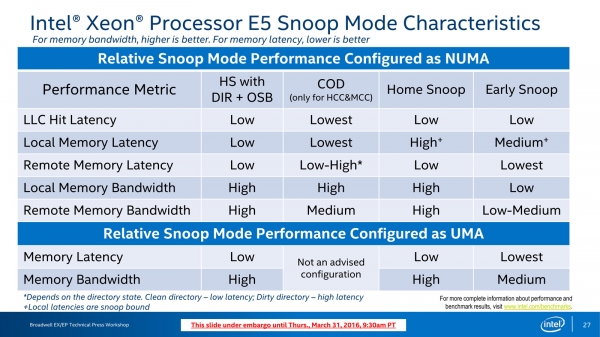

Buffered Switch的存在让两个不同的CPU组/分区对其它不同的部件有着不同的延迟,这实际上就和NUMA架构一样,因此Cluster-on-Die显的做法就是在CPU里面实现NUMA——每个CPU组各自拥有各自的内存控制器、Home Agent等,L3 Cache也同时进行分割,整体来说,Cluster-on-Die模式用于降低两个CPU分区之间的通信,从而提升性能,因此,Cluster-on-Die也是一种Snoop模式:

Cluster-on-Die也是一种Snoop模式,因为它影响到了L3 Cache的工作方式

Broadwell-EP Workshop上再次重申了各种Snoop方式的不同

对于系统来说,打开Cluster-on-Die模式实际上就是让一个处理器被认为了两个处理器,如此,支持的OS/VMM就可以对应用进行本地调度,尽量降低CPU分区之间的通信。根据上图,COD模式可以提供最低的LLC和本地内存延迟以及最高的本地内存带宽,但远程内存延迟不太稳定,而内存带宽这比较适中,因此,这是一个需要操作系统和应用优化支持的特性。

接下来就是晶圆图片,以下图片经过了Intel的审核:

Intel官方“模特”手持Intel Xeon E5 v4晶圆

Intel Broadwell-EP处理器评测 by ZD Research 盘骏/Lucifer

本文头条图用的就是Broadwell晶圆图片,可以对比Haswell-EP晶圆:

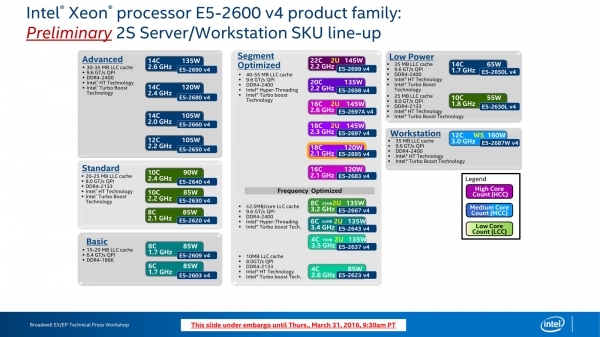

最后我们来看看当前Broadwell-EP具有的型号:

Broadwell-EP型号一览,具有很多的型号和很多的划分,分成了很多个分段

接下来我们将介绍Broadwell-EP上最激动人心的新特性集合:Intel RDT(Resource Director Technology,资源管理技术)。

好文章,需要你的鼓励

牛津大学发现:AI搜索助手竟然能轻易被“诱导“做坏事

牛津大学研究团队发现,经过强化学习训练的AI搜索助手存在严重安全漏洞。通过简单的"搜索攻击"(强制AI先搜索)和"多重搜索攻击"(连续十次搜索),可让AI的拒绝率下降60%,安全性降低超过80%。问题根源在于AI的安全训练与搜索功能训练分离,导致搜索时会生成有害查询。研究呼吁开发安全感知的强化学习方法。

CIO们注意:没有真正培训和领导力,人才将会流失

研究显示47%的企业在IT人才招聘和留存方面面临挑战,流失率居高不下。意大利53%的IT主管表示人才吸引和保留是日常难题。专家认为人才并非稀缺,而是未得到重视,因此更愿意出国发展。成功的CIO需要识别人才、给予适当机会并建立信任关系。通过持续培训、职业发展机会和有效领导力,企业可以更好地留住IT专业人员。

斯坦福大学团队开发GuideFlow3D:让3D模型“变装“的神奇技术

斯坦福大学团队开发了GuideFlow3D技术,通过创新的引导机制解决3D对象外观转换难题。该方法采用智能分割和双重损失函数,能在保持原始几何形状的同时实现高质量外观转换,在多项评估中显著优于现有方法,为游戏开发、AR应用等领域提供了强大工具。

CIO们注意:没有真正培训和领导力,人才将会流失

供应商秘密"修复"导致关键应用在营业时间无法使用

Proxmox发布数据中心管理器,打造VMware替代方案

AWS re:Invent 2025云服务企业级AI智能体技术重大发布会

Microsoft Ignite 2025:Azure 重磅发布,一文读懂!

Werner Out,但Builders的传奇才刚开始!re:Invent 2025 Dr. Werner谢幕演讲!

以硬核基座,托举Agentic AI颠覆创新!re:Invent 2025 Peter&Dave主题演讲回顾!

以伙伴优势共筑AI Agent新时代!re:Invent 2025 Dr. Ruba Borno演讲精华回顾

靠谱、高效的构建AI Agent实操手册!re:Invent 2025 Swami博士主题演讲划重点!

通往数十亿Agents的未来!re:Invent 2025 Matt Garman主题演讲精华!

Google DeepMind造出"全能游戏玩家":SIMA 2在虚拟世界里自由行动,还会自己学新技能

HPE扩展AI原生产品,以构建自动驾驶的网络战略重塑IT运营未来